딥러닝 101 - 3강. 순환신경망 RNN, Recurrent Neural Networks | Deep Learning 101

이 영상은 순환신경망 RNN의 개념부터 순전파·역전파(BPTT)까지, 수식과 숫자 예제를 통해 꽤 깊이 있게 파고드는 강의입니다. 시계열 데이터 처리의 직관과 함께 실제 계산 과정을 하나하나 따라가 보고 싶은 학습자에게 잘 맞는 구성입니다.

[AI 인공지능 머신러닝 딥러닝/딥러닝] - 딥러닝 101 - 무료 강의 전체 소개 | Deep Learning 101

딥러닝 101 - 무료 강의 전체 소개 | Deep Learning 101

딥러닝 101 재생목록은 CNN부터 트랜스포머, VAE, ResNet까지 현대 딥러닝의 핵심 개념을 한 번에 훑을 수 있는 입문·중급용 강의 시리즈입니다. 실습 위주의 설명과 직관적인 비유가 많아서, 수식에

inner-game.tistory.com

RNN의 개념과 직관적 이해

영상의 초반부에서 강의자는 RNN을 “과거 정보를 기억하며 새로운 입력을 처리하는 신경망”으로 정의하고, 주식 가격·문장·악보처럼 순서가 중요한 데이터에 적합하다는 점을 먼저 짚습니다. CNN이 이미지의 공간적 패턴을 다룬다면, RNN은 시계열의 시간적 패턴을 학습한다는 대조를 통해 두 모델의 차이를 한눈에 이해하게 합니다.

recorent 뉴럴 네트워크 약자로 시계열 데이터와 같은 연속적인 정보를 처리할 때 많이 사용되는 신경망입니다.

기본적으로 과거의 정보를 기억하면서 새로운 정보를 처리하는 것입니다.

영어–한국어 번역 예시에서 ‘baseball bat’ 문장을 가지고, 앞 단어 baseball이 내부 상태 h에 반영되고, 이 상태가 나중에 bat을 “박쥐”가 아닌 “방망이”로 번역하도록 확률을 바꾸는 과정을 설명하는데, 이 부분이 RNN의 핵심 직관인 “문맥(컨텍스트)을 기억하는 hidden state”를 아주 구체적으로 보여줍니다.

구조와 순전파: 원-핫 벡터에서 softmax까지

중반부에서는 RNN 구조를 시간축으로 “옆으로 펼쳐” 그린 뒤, 각 시점마다 입력 x t , 은닉 상태 h t , 출력 y t 가 어떻게 계산되는지 순서대로 따라갑니다. 입력은 설명의 단순화를 위해 짧은 길이의 원-핫 벡터로 설정하고, ‘baseball’, ‘bat’ 두 단어로 이루어진 시퀀스를 예시로 들어 실제 숫자를 대입해 내부 연산을 계산합니다. 은닉 상태 h t =tanh(Wh t−1 +Ux t ) 꼴의 식으로, 출력 전 단계는 o t =Vh t , 최종 출력은 softmax를 적용한 y t =softmax(o t )로 정의하며, 각 행렬과 벡터에 구체적인 값을 채운 뒤 직접 곱셈·덧셈을 수행해 결과 숫자를 보여줍니다. 이렇게 해서 “RNN도 결국은 행렬곱과 비선형 함수의 반복”이라는 사실을 눈으로 확인할 수 있습니다.

손실함수와 BPTT의 큰 흐름

순전파로 각 시점의 예측 y ^ t 를 얻은 후, 실제 정답과의 차이를 손실(loss)로 정의하는데, 여기서는 분류 문제에 널리 쓰이는 크로스 엔트로피(cross entropy)를 사용합니다. 강의자는 softmax와 크로스 엔트로피 조합이 역전파 계산을 단순하게 만들어 준다는 점도 짚어, 뒤에 나올 미분 전개에 자연스럽게 연결시킵니다. 이후 RNN의 역전파가 “시간을 따라 펼친 네트워크에 대한 오차역전파”라는 점을 강조하며, 이를 BPTT(Backpropagation Through Time)라고 부른다고 설명합니다. 결국 우리가 업데이트해야 하는 것은 세 개의 가중치 행렬 V,W,U이며, 목표는 손실을 줄이는 방향으로 이 가중치들의 기울기를 구하는 것이라는 점을 명확히 정리합니다.

기울기 계산: V, W, U에 대한 미분

강의의 후반부는 수식과 숫자가 집중되는 구간으로, 먼저 V에 대한 기울기 ∂L/∂V부터 연쇄법칙으로 전개해 나갑니다. softmax–크로스 엔트로피 조합 덕분에 ∂L/∂o t = y ^ t −y t 꼴로 깔끔해진다는 점을 활용하여, 각 시점별 기울기를 합산하는 구조를 보여주고 실제 숫자 대입까지 수행합니다.

이어지는 ∂L/∂W 계산이 이 강의의 하이라이트 중 하나입니다. 시간 t 2 의 손실 L 2 가 현재 시점 h 2 뿐 아니라 이전 시점 h 1 을 거쳐 간접적으로도 W에 영향을 준다는 점을 그림과 수식으로 풀어내면서, 왜 BPTT에서 그래디언트가 시간축을 따라 “연쇄적으로” 전달되는지 명확하게 보여줍니다. tanh의 도함수 1−h 2 를 활용해 식을 분리하고, 동일한 항을 재사용하면서 계산을 정리해 가는 과정도 단계별로 설명합니다.

마지막으로 ∂L/∂U는 ∂L/∂W와 유사한 패턴으로 전개되며, 앞에서 도출한 일부 중간 결과를 재사용해 효율적으로 정리할 수 있음을 보여줍니다. 이렇게 해서 세 개의 기울기 ∂L/∂V,∂L/∂W,∂L/∂U를 모두 얻고, 결국 경사하강법으로 가중치를 업데이트하는, 전형적인 딥러닝 학습 루프까지 연결됩니다.

학습상의 고려와 영상의 의의

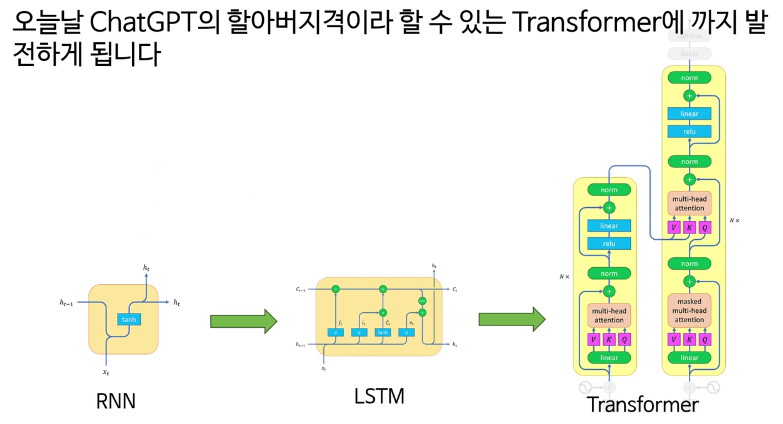

영상 말미에서 강의자는 실제 구현에서는 초기 은닉 상태 h 0 를 단순히 0 벡터로 두기보다는, 이전 시퀀스의 마지막 히든 상태를 이어받아 사용하는 경우가 많다는 점을 언급하며, 여기서는 계산 단순화를 위해 0으로 두었다고 선을 그어 줍니다. 또한 BPTT가 시간축이 길어질수록 복잡해지고, 실제로는 그래디언트 소실·폭발을 막기 위해 Truncated BPTT나 LSTM·GRU 같은 변형 모델이 등장했다는 점을 간접적으로 연결해, 후속 학습을 위한 방향도 제시합니다.

이 강의는 “RNN이 무엇인지 얼추 안다”에서 그치지 않고, 순전파와 역전파가 실제 숫자 수준에서 어떻게 돌아가는지 한 번쯤 끝까지 따라가 보고 싶은 학습자에게 특히 유익한 콘텐츠입니다. ChatGPT 같은 현대 언어모델의 이론적 뿌리가 되는 고전 RNN을 깊이 이해하고 싶다면, 강의 내용을 정리해 두고 필요할 때마다 다시 꺼내 보기 좋은 레퍼런스로 삼을 만한 영상입니다.

관련 글

[AI 인공지능 머신러닝 딥러닝/딥러닝] - 딥러닝 101 - 5강. LSTM, 초보자를 위한 안내서 | Deep Learning 101

딥러닝 101 - 5강. LSTM, 초보자를 위한 안내서 | Deep Learning 101

이 영상은 LSTM이 등장하게 된 배경부터 구조·순전파·역전파 알고리즘까지, “왜 이렇게 설계됐는지”를 직관과 수식으로 함께 풀어 주는 이론 중심 강의입니다. 특히 RNN의 장기 의존성 문제와

inner-game.tistory.com