혁펜하임의 “탄탄한” 컨벡스 최적화 (Convex Optimization) 1강

혁펜하임의 “탄탄한” 컨벡스 최적화는 머신러닝·딥러닝을 공부하는 사람들이 ‘최적화’를 진짜 수학적으로, 그러면서도 직관적으로 이해하도록 도와주는 한국어 강의 시리즈입니다. 강의의 전체 구성, 수강 난이도, 어떤 수학/ML 배경이 연결되는지, 그리고 어떻게 활용하면 좋은지는 아래의 포스팅에 정리되어 있습니다.

[AI 인공지능 머신러닝 딥러닝] - 혁펜하임의 “탄탄한” 컨벡스 최적화 (Convex Optimization) 강의 소개

혁펜하임의 “탄탄한” 컨벡스 최적화 (Convex Optimization) 강의 소개

혁펜하임의 “탄탄한” 컨벡스 최적화는 머신러닝·딥러닝을 공부하는 사람들이 ‘최적화’를 진짜 수학적으로, 그러면서도 직관적으로 이해하도록 도와주는 한국어 강의 시리즈입니다.

inner-game.tistory.com

[최적화] 1-1강. 혁펜하임의 "탄탄한" 컨벡스 최적화 (Convex Optimization)

1강은 본격적인 수식보다 “이 과목에서 무엇을 배우고, 왜 최적화를 해야 하는지”에 초점을 맞춘 짧은 소개 시간입니다.

1-1강에서 하는 이야기

1-1강에서는 먼저 이 강의 전체에서 다루게 될 큰 주제들을 간단히 훑어 줍니다.

컨벡스 집합·컨벡스 함수·컨벡스 최적화 문제·KKT 조건 같은 키워드들을 앞으로 차근차근 다루겠다는 로드맵을 제시하고, 각 파트가 어떤 느낌의 내용인지 맛보기 수준으로 언급해 줍니다.

왜 최적화를 공부해야 하는지

영상 후반부에서는 “왜 이렇게까지 최적화, 특히 컨벡스 최적화를 공부해야 하는가?”라는 질문에 답하려고 합니다.

변수와 코스트(비용/에러) 함수가 있을 때, 코스트를 최소로 만드는 변수를 찾는 것이 최적화의 목표라는 직관적인 그림을 먼저 그리고, 머신러닝에서 이 코스트가 곧 에러 함수라서 학습 자체가 최적화 문제로 표현된다는 점을 강조합니다.

이 강의를 듣는 포인트

1-1강은 수식이나 정의를 외우기보다는 “아, 이 과목이 이런 방향으로 가는구나”를 감 잡는 데 의미가 있는 영상입니다.

특히 머신러닝·딥러닝을 이미 하고 있는 사람이라면, 앞으로 보게 될 컨벡스 이론들이 단순한 이론이 아니라 실제 모델 학습과 어떻게 연결될지 미리 상상하면서 들어 두면 좋습니다.

[최적화] 1-2강. 극대 & 극소, 제대로 아시는거 맞아요? (헷갈리는 용어들 정리)

이 영상은 혁펜하임 “탄탄한 컨벡스 최적화” 1-2강으로, 최적화 문제에서 가장 기초가 되는 용어들(목적함수, 제약, feasible set, local/global extremum)을 깔끔하게 정리해 주는 내용입니다.

본격적인 컨벡스 이론으로 들어가기 전에, 극대·극소와 해 집합을 둘러싼 헷갈리기 쉬운 개념을 정확한 정의와 예시로 재정비하는 강의라고 볼 수 있습니다.

목적함수와 제약조건

강의의 첫 부분에서는 최적화 문제를 “무엇을 얼마나 크게/작게 만들 것인가”라는 틀로 보고, 그 역할을 하는 함수가 목적함수(objective function)라고 설명합니다.

동시에, 변수들이 아무 값이나 가질 수 있는 것이 아니라 등식·부등식 같은 제약조건(constraints)을 만족해야 하며, 이 제약들이 문제의 형태(예: 컨벡스인지 여부)를 결정한다는 점을 짚습니다.

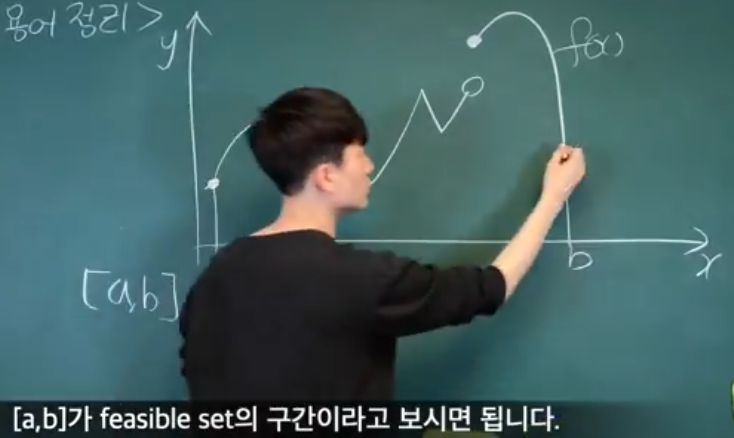

Feasible solution과 feasible set

이어서 “제약을 모두 만족하는 해”를 feasible solution(실현 가능한 해)라고 부르고, 이런 해들을 전부 모아 놓은 집합을 feasible set이라고 정의합니다.

최적화의 목표는 이 feasible set 안에서 목적함수 값을 최소(또는 최대)로 만드는 점, 즉 optimal solution을 찾는 것이라는 구조를 그림과 함께 다시 정리합니다.

로컬/글로벌 극소·극대 개념

강의의 후반부 핵심은 local minimum/maximum과 global minimum/maximum의 차이를 직관적으로 이해하는 부분입니다.

어떤 점이 미분 가능하지 않아도 주변 작은 이웃에서 가장 작으면 local minimum이 될 수 있고, 전체 feasible set 중에서 가장 작은 값을 주는 점이 따로 있을 경우 그 점을 global minimum으로 부른다는 식으로, 극대·극소의 엄밀한 정의를 예시와 함께 풀어 줍니다.

왜 이 강의가 중요한지

1-2강에서 나오는 개념들은 이후 컨벡스 최적화에서 “어떤 점이 진짜 최적인가?”, “local min과 global min이 언제 일치하는가?”를 논의할 때 반복해서 사용되는 언어입니다.

따라서 이 영상을 통해 high-school 미적분 수준에서 어렴풋이 알고 있던 극대·극소 개념을 최적화의 관점에서 다시 정리해 두면, 뒤에 나오는 컨벡스 정의, KKT 조건, 최적성 조건들을 이해하기 훨씬 수월해집니다.

[AI 인공지능 머신러닝 딥러닝] - 혁펜하임의 “탄탄한” 컨벡스 최적화 (Convex Optimization) 2강

혁펜하임의 “탄탄한” 컨벡스 최적화 (Convex Optimization) 2강

혁펜하임의 “탄탄한” 컨벡스 최적화는 머신러닝·딥러닝을 공부하는 사람들이 ‘최적화’를 진짜 수학적으로, 그러면서도 직관적으로 이해하도록 도와주는 한국어 강의 시리즈입니다.

inner-game.tistory.com