이 영상은 생성적 적대 신경망(GAN)의 아이디어와 구조, 그리고 제너레이터·디스크리미네이터가 이진 크로스엔트로피 손실을 두고 서로 경쟁하며 학습하는 과정을 직관적 비유와 간단한 수식 예제로 설명하는 입문 강의이다. 특히 “위조 화가 vs 감별사” 비유와 실제 숫자를 이용한 손실·기울기 계산으로, 적대적 학습의 흐름을 감각적으로 이해하기 좋다.

[AI 인공지능 머신러닝 딥러닝/딥러닝] - 딥러닝 101 - 무료 강의 전체 소개 | Deep Learning 101

딥러닝 101 - 무료 강의 전체 소개 | Deep Learning 101

딥러닝 101 재생목록은 CNN부터 트랜스포머, VAE, ResNet까지 현대 딥러닝의 핵심 개념을 한 번에 훑을 수 있는 입문·중급용 강의 시리즈입니다. 실습 위주의 설명과 직관적인 비유가 많아서, 수식에

inner-game.tistory.com

생성 모델로서의 GAN 개념

· 강의는 먼저 딥러닝 모델을 판별 모델(분류·회귀)과 생성 모델로 나누고, 인간이 “개념을 분류도 하지만 새로운 이미지를 그려 내기도 한다”는 점에서 생성 모델의 중요성을 짚는다.

· StyleGAN 얼굴 생성, 스타일 변환(말↔얼룩말, 모네↔사진), 초해상도(SRGAN)처럼 실제 애플리케이션 사례들을 보여 주며, GAN이 생성 모델 붐의 출발점이 된 역사적 의미를 간략히 소개한다.

제너레이터와 디스크리미네이터 구조

· GAN은 “위조 화가” 역할의 제너레이터(Generator)와 “감별사” 역할의 디스크리미네이터(Discriminator), 두 개의 신경망으로 이루어진다.

· 제너레이터는 랜덤 잠재 벡터 z z를 입력으로 받아, 실제 데이터(예: 사람 얼굴, RGB 벡터 등)와 구분하기 어려운 샘플을 생성하는 것이 목표다.

· 디스크리미네이터는 입력이 진짜(real)인지 가짜(fake)인지 구분하는 이진 분류기이며, 출력은 0~1 사이의 스칼라(“진짜일 확률”)로 시그모이드를 사용해 표현한다.

손실 함수와 학습 목표

· 디스크리미네이터는 진짜 샘플에 대해서는 1, 제너레이터가 만든 가짜 샘플에 대해서는 0을 출력하도록 학습되며, 이 때 이진 크로스엔트로피(Binary Cross Entropy) 손실을 사용한다.

· 영상에서 제시하는 손실은

· · 진짜 데이터에 대한 손실: − log D ( x ) −logD(x)

· · 가짜 데이터에 대한 손실: − log ( 1 − D ( G ( z ) ) ) −log(1−D(G(z)))

를 합한 형태로, 디스크리미네이터는 이 합을 최소화(또는 로그 항을 최대화)하도록 학습된다.

· 반대로 제너레이터는 G ( z ) G(z)가 디스크리미네이터에게 “진짜처럼” 보이도록, − log D ( G ( z ) ) −logD(G(z))를 최소화(혹은 log D ( G ( z ) ) logD(G(z))를 최대화)하는 방향으로 학습된다고 설명한다.

이제부터는 손실함수부터 시작된 오류가 어떻게 역전파 되는지 알아볼 차례입니다

GAN모델의 손실함수는 이진 크로스 엔트로피 binary cross-entropy (BCE)함수를 기반으로 하고 있습니다

사실상 GAN모델은 주어진 이미지가 진짜 데이터(1)냐 가짜 (0)냐 둘 중 하나만 판별해야 하기 때문에 이진binary 형태의 손실함수가 합당하고,

또 지난 영상에서 본 바 처럼, 크로스 엔트로피 손실함수가 MSE에 비해 빨리 정답쪽으로 수렴하는 경향이 크기 때문에,

이진 크로스 엔트로피가 GAN모델의 손실함수로 적당해 보입니다.

우선 discriminator의 손실함수부터 살펴보도록 하겠습니다.

먼저 진짜 데이터가 들어올 경우를 가정해보면,

진짜 데이터의 경우는 discriminator의 출력값이 1이어야 하기 때문에,

손실함수는 이렇게 바꾸어 쓸수가 있습니다

이 부분은 0이 되어 사라지고,

그리고 진짜 데이터의 경우는 generator와 아무 관련이 없기 때문에,

진짜 데이터를 받은 discriminator의 출력값 (확률)을 이렇게 다시 쓸 수 있습니다

그래서 GAN모델을 학습시킬 때, 만약 입력이 진짜 데이터라면,

log(𝐷 𝑥 )를 최대화 하는 것이 앞의-와 만나서 손실을 최소로 만들 수 있음을 알 수 있습니다.

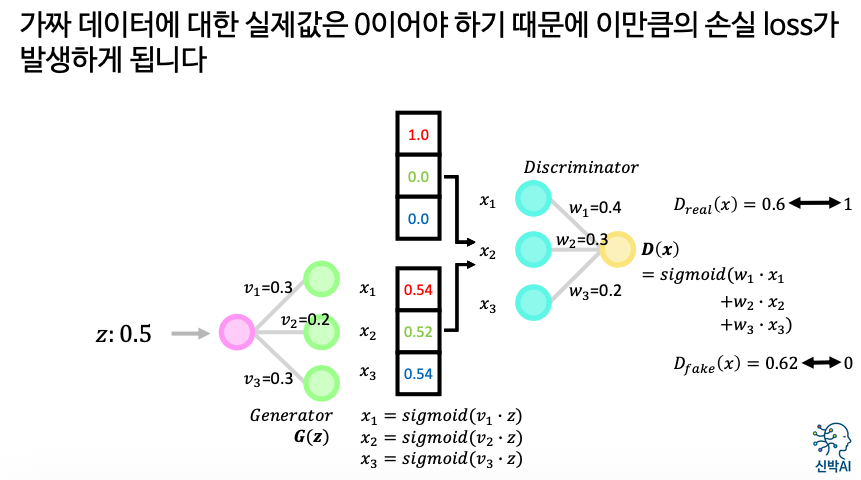

숫자로 따라가는 순전파·역전파 예제

· 강의에서는 입력·가중치 차원을 극단적으로 줄인 장난감 GAN을 설정해,

· · 제너레이터가 단순한 RGB 벡터를 출력하고

· · 진짜 빨간색 RGB를 타깃으로 학습하는 상황을 가정한다.

· 이때 진짜·가짜 각각에 대해 디스크리미네이터의 출력과 손실 값을 직접 계산하고, 이진 크로스엔트로피의 미분과 시그모이드의 도함수 σ ′ ( x ) = σ ( x ) ( 1 − σ ( x ) ) σ ′ (x)=σ(x)(1−σ(x))를 이용해 디스크리미네이터 가중치의 기울기를 체인 룰로 전개해 나간다.

· 이어 제너레이터 쪽에서는 손실이 디스크리미네이터 출력 D ( G ( z ) ) D(G(z))를 거쳐 G G의 가중치까지 어떻게 역전파되는지, 중간 항들을 하나씩 계산해 실제 수치로 보여 줌으로써 “제너레이터는 디스크리미네이터를 속이는 방향으로 업데이트된다”는 흐름을 명확히 드러낸다.

적대적 학습의 직관과 의의

· 위조 화가와 감별사가 서로의 실력을 끌어올리는 비유를 GAN 학습에 대응시키면서, 디스크리미네이터가 정교해질수록 제너레이터도 더 현실적인 샘플을 만들도록 압박받는, 상호 경쟁 구조를 강조한다.

· 이런 적대적 학습 덕분에 GAN은 명시적으로 확률밀도함수 p ( x ) p(x)를 모델링하지 않으면서도, 실제 데이터 분포와 매우 비슷한 샘플을 생성해 내는 강력한 생성 모델로 자리 잡았다는 점을 간단히 언급한다.

결국 이 영상은 “GAN이 무엇을, 왜, 어떻게 학습하는지”를 직관적 비유–구조도–이진 크로스엔트로피 수식–간단한 수치 예제까지 한 흐름으로 연결해 주는, 생성 모델 입문자용 GAN 개념 정리 강의라고 정리할 수 있다.

[AI 인공지능 머신러닝 딥러닝/딥러닝] - 딥러닝 101 - 13강. Softmax와 Cross-Entropy의 미분 | Deep Learning 101

딥러닝 101 - 13강. Softmax와 Cross-Entropy의 미분 | Deep Learning 101

이 영상은 소프트맥스–크로스엔트로피 조합의 역전파에서 늘 등장하는 “기울기가 y ^ − y y ^ −y로 단순화된다”는 결과를 처음부터 끝까지 미분으로 직접 도출해 주는 이론 중심 강의이다. R

inner-game.tistory.com