이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 7강 Universal Approximation Theorem (보편 근사 정리)

[AI 인공지능 머신러닝 딥러닝] - 이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 - 무료 강의 및 책 소개

이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 - 무료 강의 및 책 소개

한국어로 딥러닝 공부해봤다는 사람중에 안들어 본 사람이 없을것 같은 이지 딥러닝 시리즈 입니다. 이 강의는 유투브로 제공되며 책도 있습니다. 이지 딥러닝 유투브 강의이지 딥러닝 유투브

inner-game.tistory.com

[Easy! 딥러닝] 7강. 영상 안 보고 풀면 천재! | Universal Approximation Theorem (보편 근사 정리)

이 강의의 핵심은 “히든 레이어가 단 한 층만 있는 MLP도 노드 수만 충분히 많으면, 거의 어떤 연속 함수든 원하는 정확도로 근사할 수 있다(보편 근사 정리, Universal Approximation Theorem)”는 사실을 직관적으로 보여주는 것입니다.

보편 근사 정리가 말하는 것

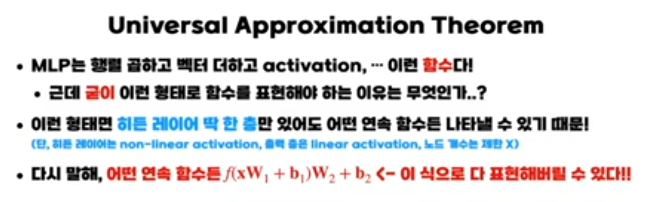

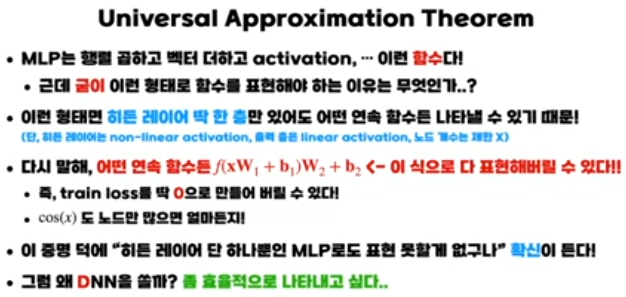

강의에서는 MLP를 “곱하고 더하고 비선형 activation을 통과시키는 연속된 함수”로 본 뒤, 이런 구조를 가진 네트워크가 놀라울 만큼 표현력이 크다는 점을 설명합니다. 비선형 activation(예: step, sigmoid, ReLU 등)을 쓰고, 히든 레이어를 단 1층만 두더라도, 노드 수를 충분히 늘리면 임의의 연속 함수를 임의의 작은 오차 이하로 근사할 수 있다는 것이 보편 근사 정리입니다. 즉, x↦f(x)가 연속 함수라면, 적절한 가중치·바이어스를 갖는 1-히든-레이어 MLP N(x)가 존재해서 ∣N(x)−f(x)∣를 원하는 만큼 작게 만들 수 있습니다.

“깍두기 함수”로 직관적인 증명

강의에서는 유닛 스텝 함수(Heaviside step)를 이용해 직관적인 구성적 증명을 보여줍니다.

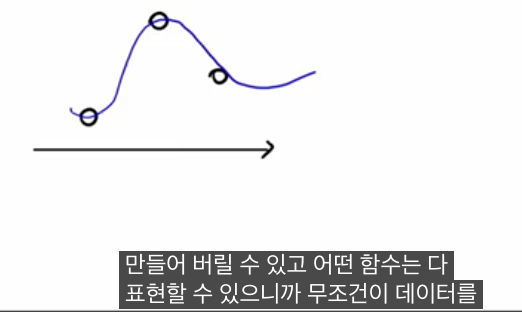

- 히든 레이어에서 스텝 함수를 이용해, 특정 구간에서만 1이고 바깥에서는 0인 “직사각형(깍두기) 함수” 하나를 만들 수 있습니다.

- 출력층에서 이 깍두기에 적절한 가중치를 곱해 더하면, 특정 구간에서 원하는 높이를 갖는 ‘막대’를 만들 수 있습니다.

데이터 포인트가 (x i ,y i )로 주어졌을 때, 각 점 주변에 이런 작은 깍두기를 하나씩 세워서 높이를 y i 에 맞춰 주면, 합쳐진 함수가 모든 데이터를 정확히 지나가도록(트레인 로스 0) 만들 수 있습니다. 점들을 더 빽빽하게 잡으면, 코사인이나 다항식 같은 연속 함수의 그래프도 “깍두기 합”으로 점점 더 잘 근사할 수 있고, 그 깍두기 합을 1층 MLP가 구현하기 때문에 “어떤 연속 함수든 표현 가능하다”는 결론에 도달합니다.

얕은 신경망 vs 딥 신경망

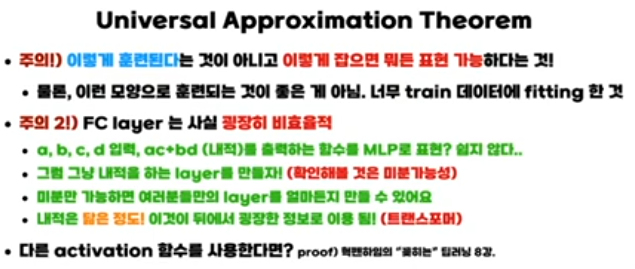

보편 근사 정리는 “표현력” 관점에서, 단 한 층만 있어도 충분하다는 존재 정리입니다. 하지만 강의에서도 강조하듯, 실제로는 다음과 같은 이유로 깊은 네트워크를 사용합니다.

- 1층으로만 표현하려면 필요한 노드 수가 기하급수적으로 커져 비효율적입니다.

- 여러 층을 두면, 중간 층에서 이미 학습한 표현을 재사용하면서 더 적은 파라미터로 복잡한 함수를 구현할 수 있습니다.

따라서 “얕은 네트워크로도 이론상 무엇이든 근사 가능하지만, 실전에서는 깊이(depth)를 활용해 더 효율적이고 일반화 잘 되는 모델을 만든다”는 것이 실무적인 결론입니다.

이 강의에서는 인공 신경망을 “입력에 대해 어떤 함수를 계산해 주는 기계”로 보고, 히든 레이어가 단 한 층뿐인 MLP도 노드 수만 충분하다면 임의의 연속 함수를 원하는 수준까지 근사할 수 있다는 보편 근사 정리(Universal Approximation Theorem)를 직관적인 깍두기 함수 예제로 설명합니다. 유닛 스텝이나 시그모이드 같은 비선형 활성 함수를 이용하면, 특정 구간에서만 값이 1인 작은 직사각형 함수들을 여러 개 만들 수 있고, 이를 적절히 쌓아 올리면 복잡한 곡선도 정밀하게 따라갈 수 있기 때문에, 회귀식이나 삼각함수 등 별도의 수식을 쓰지 않고도 인공 신경망 하나로 “어떤 연속 함수든” 표현할 수 있게 됩니다. 다만 실제 응용에서는 이런 얕은 네트워크가 비효율적으로 많은 노드를 요구하므로, 표현력은 그대로 유지하면서도 파라미터 수와 계산량을 줄이고 일반화 성능을 높이기 위해 깊은 신경망 구조를 사용한다는 점이 뒤이어 소개됩니다.

[AI 인공지능 머신러닝 딥러닝] - 이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 8강 기울기소실 ReLU, 정규화, 과적합

이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 8강

[AI 인공지능 머신러닝 딥러닝] - 이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 - 무료 강의 및 책 소개 이지 딥러닝 - 혁펜하임 | Easy! 딥러닝 - 무료 강의 및 책 소개한국어로 딥러닝 공부해봤다는 사람중

inner-game.tistory.com